Про це повідомляє видання 9to5mac.

На iOS з’явиться функція, яка дасть змогу батькам дізнаватися про випадки, коли їх діти відправлятимуть чи отримуватимуть фото чи інший контент інтимного характеру (на кшталт дитячого порно). Йдеться про спеціальну технологію з виявлення дитячої порнографії, яку завантажать в iCloud. Нововведення має з’явитися в США до кінця року.

Сканування відбуватиметься на телефоні дитини, а сповіщення будуть відправляти на телефони батьків. На думку експертів з кібербезпеки та представників служб захисту дітей, такий підхід компанії ефективний та раціональний.

Йдеться про систему neuralMatch. В Apple оголосили про три нових способи забезпечення захисту дітей на iPhone, iPad та Mac. Зокрема, це нові функції безпеки спілкування в текстових повідомленнях (iMessage), покращення пошуку матеріалів щодо сексуального насилля над дітьми (CSAM) в iCloud та оновлення функцій Siri та пошуку.

Текстові повідомлення (iMessage)

В Apple пояснили, що якщо дитина отримає чи захоче відправити фотографії інтимного характеру, то отримає спеціальне сповіщення про загрозу. Якщо таке фото отримає дитина, то зображення буде розмитим. Якщо дитина все одно захоче подивитися фото – побачить повідомлення про те, чому світлина зашифрована. Коли дитина все одно намагатиметься відкрити зображення, батьки через iCloud Family отримають сповіщення з коротким посиланням про отримання додаткової допомоги. Теж саме відбуватиметься, якщо дитина відправлятиме такі фотографії.

В Apple пояснили, що телефони аналізуватимуть вкладені зображення на предмет того, чи є вони відвертими та сексуальними. Поки алгоритм не перевірить зображення – фото в iMessage буде розмитим.

Обмеження діятимуть для дітей віком до 13 років.

Нова функція з’явиться в оновленнях iOS 15, iPadOS 15 та macOS Monterey. Поки що функція буде доступна тільки на території США.

CSAM

В Apple оголосили про нові кроки щодо боротьби з поширенням матеріалів про сексуальне насилля над дітьми (CSAM, Certified Software Asset Manager). В Apple пояснили, що CSAM – контент, в якому зображують відверті сексуальні дії за участі дітей чи дитини (дитяче порно).

Apple шукатиме CSAM, якщо контент зберігається в iCloud Photos. Ця функція частково почала працювати вже сьогодні. Apple почав відкривати зображення CSAM, якщо ті знаходяться в iCloud Photos. Після цього Apple може повідомляти про випадки CSAM до Національного центру зниклих безвісти дітей, організації, яка працює, як комплексна агенція звітності для CSAM та тісно співпрацює з правоохоронними органами.

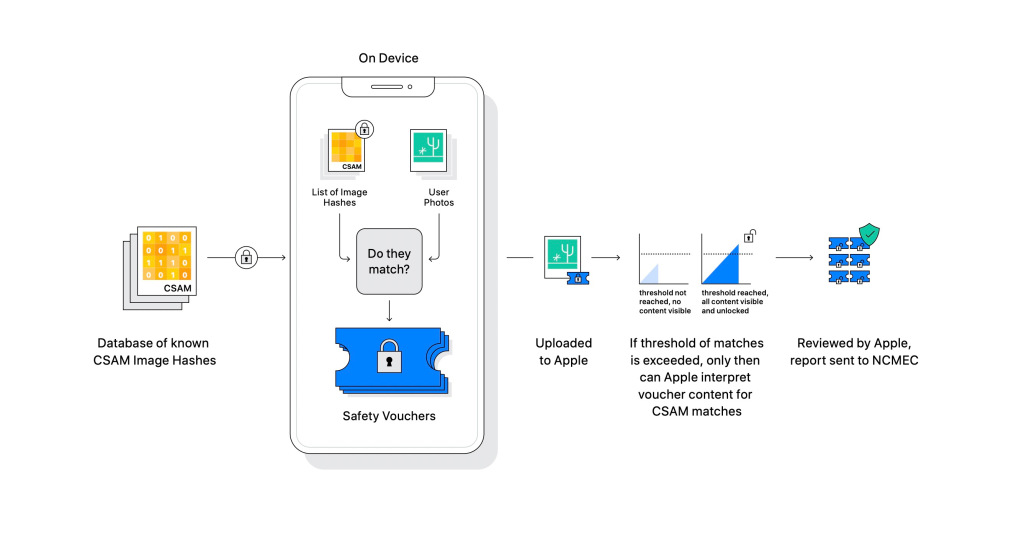

В Apple вкотре повторили, що їх метод виявлення CSAM розробляється із врахуванням правил конфіденційності користувачів. Тобто Apple аналізує зображення на вашому пристрої, щоб побачити, чи є якість збіги з базовими зображеннями CSAM, попередньо встановленим Національним центром зниклих безвісти дітей. Всі збіги аналізують на різних девайсах Apple. При цьому, Apple трансформує базу даних Національного центру зниклих безвісти дітей в “нечитабельний набір хешів, який надійно зберігається на пристроях користувачів”.

В Apple роботу алгоритму пояснили так:

“Йдеться про процес зіставлення, який засновано на криптографічній технології, яку називають перетином приватних наборів (PSI). Вона визначає наявність збігів, не розкриваючи результат. Ця технологія дає змогу дізнатися, чи збігається хеш зображення із заданими хешами зображень в CSAM. При цьому, не потрібно вказувати на відсутність збігів. PSI не дозволяє користувачу дізнатися, чи були збіги”.

Якщо на девайсі знаходять збіг, то там же автоматично створюється ваучер криптографічної безпеки, який закодовує результат збігів. Після цього починає використовуватися технологія, яку називають пороговим розподілом секрету. Це гарантує, що вміст ваучера безпеки не може бути інтерпретовано Apple, якщо обліковий запис iCloud Photos не перевищує граничне значення контенту CSAM. Яке граничне значення – не повідомляється.

“Приміром, якщо секрет розділено на тисячу частин, а поріг – 10, то секрет може бути відновлено з будь-яких 10 частин до тисячі. При цьому, якщо доступно тільки дев’ять, секрет не поширюється”, – пояснили в Apple.

В Apple не назвали конкретне граничне значення, яке будуть використовувати, тобто кількість збігів CSAM, необхідних для того, аби інтерпретувати вміст ваучерів безпеки. Але як тільки цей поріг буде перетнуто, Apple буде розглядати звіт, аби підтвердити кількість збігів, а після цього заблокує обліковий запис користувача та відправить з0віт до Національного центру зниклих безвісти дітей.

Така технологія із встановленим граничним значенням важлива, тому що це не дасть змоги системі самостійно негативно маркувати облікові записи. Ще один крок для підтвердження необхідності перевірки – розгляд звіту в ручному режимі. Це потрібно для того, аби запобігти помилок. Тоді користувачі зможуть подавати апеляції на відновлення облікового запису. На період проведення тестування система мала низький поріг помилок – менш як 1 на 1 трильйон за рік.

Попри те, що технологія працюватиме тільки на девайсах, Apple аналізуватиме тільки зображення, які зберігаються в iCloud Photos. Ті зображення, які зберігаються локально, проаналізовано не буде. В Apple повідомили, що система на девайсах важлива та забезпечує більшу конфіденційність, ніж сканування в iCloud.

Ця функція в Apple матиме суто технічний характер. Поки що вона буде доступна тільки на території США.

Siri та пошук

Apple внесе зміни також в Siri та функції пошуку. За їх допомогою користувачі зможуть повідомляти про CSAM та відправляти відповідні звіти. Функція спрацьовуватиме й у випадках, коли користувачі шукатимуть інформацію, пов’язану з CSAM.

“Apple розширить можливості Siri та пошуку, надаючи додаткові ресурси, аби допомогти дітям та батькам бути в безпеці в Інтернеті та отримувати допомогу в небезпечних ситуаціях. До прикладу, користувачам, які запитують Siri, як вони можуть повідомити про CSAM чи експлуатацію дітей, покажуть ресурси про те, як та куди відправити звіт”, – пояснили в компанії.

Оновлення будуть доступні в iOS 15, iPadOS 15, watchOS 8 та macOS Monterey.

Що думають експерти

Джон Кларк, президент та головний виконавчий директор Національного центру зниклих безвісти дітей:

“Розширений захист дітей Apple змінив правила гри. Оскільки так багато людей використовує продукти Apple, нові заходи безпеки здатні врятувати життя дітей, яких заманюють обманом, а потім ми бачимо їх фото в матеріалах про сексуальне насилля над дітьми. В Національному центрі у справах зниклих безвісти дітей нам відомо, що з такими злочинами можливо боротися тільки в тому випадку, коли ми твердо стоятимемо в спільному прагненні захистити дітей. ми можемо зробити це тільки тому, що наші технологічні партнери, такі як Apple, активізуються та говорять про свою підтримку. Реальність така, що конфіденційність та захист дітей можуть співіснувати. Ми аплодуємо Apple та сподіваємося на спільну роботу, аби зробити цей світ безпечнішим для дітей”.

Джулі Кордуа, генеральна директорка Thorn (міжнародна організація з боротьби торгівлею людьми, яка займається проблемами сексуальної експлуатації дітей):

“В Thorn ми віримо в право на конфіденційність в Інтернеті, в тому числі відносно дітей, сексуальні домагання до яких поширюють в Інтернеті без їх згоди. Обов’язок Apple щодо введення технологічних рішень, які збалансовують необхідність в конфіденційності з цифровою безпекою для дітей, наближає нас на крок ближче до справедливості стосовно тих, хто постраждали через сексуальне насилля. Ми маємо стати на крок ближче до світу, де кожна цифрова платформа з кнопкою завантаження призначення для пошуку CSAM в будь-якій сфері; на крок ближче до світу, де в кожної дитини є можливість бути дитиною”.

Стівен Балкам, засновник та генеральний директор Інституту сімейної онлайн-безпеки:

“Ми підтримуємо постійний розвиток підходу Apple до безпеки дітей в Мережі. Враховуючи проблеми, з якими стикаються батьки при захисті своїх дітей в Мережі, дуже важливо, аби технологічні компанії постійно вдосконалювали свої інструменти безпеки, аби реагувати на нові ризики та реальну небезпеку”.

Ексгенпрокурор Ерік Холдер:

“Історичний ріст кількості онлайн-матеріалів про сексуальне насилля над дітьми – проблема, яку необхідно вирішувати за допомогою технологічних інновацій… Нові зусилля Аpple щодо пошуку CSAM – важливий крок, який демонструє, що безпека дітей не обов’язково має бути в рамках конфіденційності… Це приклад того, що Apple намагається зробити світ кращим, крок за кроком захищаючи конфіденційність користувачів”.

Бенні Пінкас, професор факультету комп’ютерних наук Університету Бар-Ілан:

“Система Apple PSI забезпечує прекрасний баланс між конфіденційністю та корисністю й стане в пригоді при ідентифікації контенту CSAM, зберігаючи високий рівень конфіденційності користувачів та збереженні помилкових порівнянь до мінімуму”.

- Компанія Apple додасть два нових голоси до свого голосового англомовного помічника Siri в наступній версії програмного забезпечення для iPhone.

Помста за “Прямий”? Чому прихильники Порошенка раділи знищенню Харківської телевежі

Помста за “Прямий”? Чому прихильники Порошенка раділи знищенню Харківської телевежі